Corto plazo (0–2 años)

- Desinformación y fraude: deep fakes, suplantaciones por voz/texto, estafas hiperpersonalizadas y saturación informativa que erosiona la confianza pública.

- Errores de alta velocidad: “alucinaciones” en contextos críticos (sanidad, legal, finanzas), bugs introducidos por copilotos de código, y automatización de ciberataques.

- Choque laboral: sustitución/reestructuración rápida en tareas cognitivas rutinarias (back office, soporte, marketing de bajo valor), con ansiedad social y protestas sectoriales.

- Concentración de poder: dependencia de pocas empresas/hiperescalares, lock-in de nube, asimetría de datos y cómputo.

- Cuellos de botella físicos: chips, energía y agua para data centers; tensiones locales por consumo eléctrico y calor residual.

- Marco legal desfasado: autoría y derechos, responsabilidad por daños, privacidad y uso secundario de datos.

Medio plazo (3–5 años)

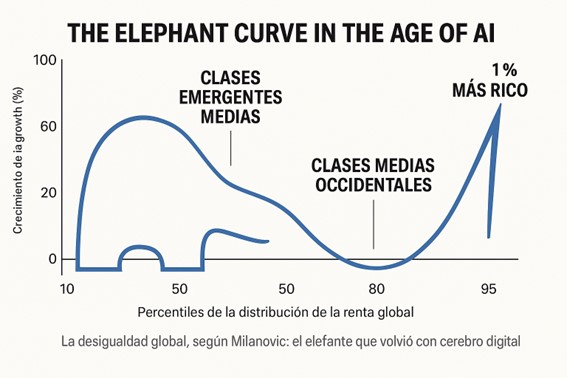

- Polarización de productividad: empresas/países “con IA” vs. “sin IA”; brechas salariales y territoriales.

- Crisis epistemológica: “prueba” audiovisual pierde valor; necesidad de cadenas de autenticidad y peritajes digitales.

- Gobernanza disputada: divergencia regulatoria (EE. UU., UE, China), “splinternet” algorítmico y barreras comerciales.

- Seguridad y geopolítica: más autonomía en sistemas militares, guerra de drones/enjambres, y escalada de ataque-defensa en ciberseguridad.

- Impacto psicosocial: sustitución de interacción humana por asistentes, soledad, adicción a acompañantes sintéticos; atrofia de habilidades.

- Dependencias críticas: interrupciones de cadena de suministro (Taiwán, materiales), o incidentes de seguridad en modelos base.

Largo plazo (6–10 años)

- Riesgo sistémico de modelos avanzados: pérdida parcial de control/interpretabilidad; agentes que optimizan objetivos mal definidos.

- Armas biológicas/químicas asistidas: reducción de barreras para diseño y optimización (requiere controles fuertes).

- Erosión de agencia humana: decisiones automatizadas opacas en justicia, crédito, salud; vigilancia ubicua, estatal o corporativa.

- Sostenibilidad: si el cómputo crece más rápido que la descarbonización, tensión climática/energética.

Principales beneficios (ya visibles y potenciales)

- Productividad general: aceleración de tareas cognitivas (redacción, análisis, programación, diseño) y de I+D.

- Ciencia y salud: descubrimiento de fármacos/materiales, diagnósticos precoces, medicina personalizada, simulaciones complejas.

- Educación: tutores personalizados, feedback inmediato, traducción y accesibilidad (discapacidad, idiomas).

- Pymes y profesionales: abarata “superpoderes” (marketing, legal básico, finanzas), democratiza la creación.

- Servicios públicos: tramitación más rápida, detección de fraude, gestión de emergencias y planificación urbana.

- Seguridad: defensa cibernética asistida, búsqueda de vulnerabilidades, monitoreo de infraestructuras.

- Eficiencia energética/industrial: optimización de procesos, mantenimiento predictivo, agricultura de precisión.

Diagnóstico prospectivo a 10 años (2035)

Escenario base: “transformación áspera, pero netamente positiva”

- La IA se integra como copiloto ubicuo en casi todos los flujos de trabajo; muchas tareas se “orquestan” entre humanos y agentes.

- La productividad crece de forma sostenida, pero desigual: sectores intensivos en información (finanzas, logística, salud, educación, administración) avanzan más rápido.

- El empleo cambia más que desaparece: decrecen tareas rutinarias, crecen roles de supervisión, diseño de procesos, seguridad y “IA de dominio”. Aparecen contratos y sindicatos adaptados a métricas algorítmicas.

- Regulación más madura: auditorías de modelos de alto riesgo, trazabilidad de datos, seguros de responsabilidad y evaluación de impacto. Persisten diferencias regionales.

- Mercados: oligopolio en cómputo y modelos frontera, pero ecosistema vivo de modelos abiertos/especializados y soluciones on-device.

- Energía: la demanda de IA obliga a una nueva capacidad eléctrica, reutilización de calor, y más renovables/almacenamiento; la eficiencia por operación mejora, pero el volumen crece.

- Seguridad: ataque-defensa en equilibrio tenso; autenticación fuerte y marcas de origen bajan el ruido, sin eliminarlo.

- Cultura/educación: autores y artes “hechas por humanos” ganan sello/valor distintivo; la escuela vira a proyectos, juicio crítico y trabajo con/contra IA.

- Europa/España: si invierte en cómputo, datos públicos de calidad y capacitación masiva, puede capturar valor en sanidad, turismo inteligente, industria y administración; si no, dependencia tecnológica y fuga de talento.

Señales tempranas para vigilar

- Coste del cómputo y acceso a GPUs/NPUs; disponibilidad eléctrica local.

- Calidad y transparencia de benchmarks (menos “marketing”, más pruebas robustas).

- Herramientas de auditoría y trazabilidad estandarizadas.

- Adopción real en PYMES y sector público (no solo pilotos).

- Incidentes serios de seguridad/biogénicos (si aparecen, el péndulo regulatorio se acelera).

Qué haría falta para el “buen caso”

- Programas de recualificación masivos (docentes, sanitarios, administración, justicia).

- Interoperabilidad y portabilidad de modelos/datos para evitar lock-in.

- Inversión en infra energía-cómputo (renovables, redes, centros de datos eficientes, edge).

- Sandboxes regulatorios con métricas de seguridad y impacto claras.

- Gobernanza internacional mínima: controles de exportación equilibrados, reporting de cómputo y canales de respuesta a incidentes.

- Políticas de datos públicos de alta calidad y etiquetados de autenticidad.

Mis interrogantes y dudas (de ChatGPT)

- Control y alineación: ¿lograremos pruebas y límites operativos fiables para modelos con capacidades abiertas y agentes autónomos?

- Epistemología social: ¿podremos reconstruir confianza en información pública cuando “ver y oír” ya no prueba nada?

- Energía: ¿la eficiencia por token/proceso ganará a la “voracidad” del uso real?

- Trabajo: ¿aparecerán suficientes empleos de alta calidad en la misma geografía y a tiempo para absorber la transición?

- Competencia y apertura: ¿sobrevivirá un núcleo abierto potente o quedará asfixiado por costes legales/computacionales?

- Bioseguridad: ¿serán efectivos los guardrails técnicos y los controles de acceso sin bloquear investigación legítima?

- Democracia vs. control: ¿quién audita a los auditores? ¿Cómo evitar que la IA refuerce tanto la censura como la manipulación segmentada?

- Cultura: ¿cómo sostener valor y significado de lo humano (autoría, responsabilidad, mérito) en un entorno de abundancia sintética?